2022. 1. 11. 02:43ㆍ기타/태스커(Tasker)

본 네이버 블로그는 모바일에 최적화되어 있습니다.

PC 유저분들은 아래 티스토리 블로그를 이용해 주세요.

Tasker plugin - AutoVoice

본 네이버 블로그는 모바일에 최적화되어 있습니다. PC 유저분들은 아래 티스토리 블로그를 이용해 주세...

blog.naver.com

안녕하세요! ICMP입니다!

저번 AutoInput 플러그인에 이어서 작성하도록 하겠습니다!

- AutoVoice -

오토 보이스는 말 그대로 음성인식 기능 확장을 탑재한 플러그인입니다.

특정 이벤트 발생 시 Ok Google이나 내부적인 음성인식 엔진을 호출하여 음성 데이터를 녹음하고 이를 텍스트로 변환한 결과와 매칭 설정할 수 있습니다.

최근에는 삼성의 빅스비나 애플의 시리와 같은 음성인식 인공지능 서비스가 등장하면서 자체적인 인식률 측면에서는 떨어지지만, Tasker와 연동이 가능하다는 점에서 사용할 가치는 충분하다고 볼 수 있습니다.

물론 무료 버전은 연동 가능한 기기 수와 일부 기능이 제한됩니다...

현재는 삼성 빅스비 기능 중 하나인 빅스비 루틴을 활용하여 일부 기능을 자동화할 수 있으나 태스커가 보다 많은 설정 환경을 제공하고 있기 때문에 보다 정밀한 동작을 수행할 수 있다고 할 수 있습니다.

아래는 AutoVoice 사용법입니다.

1. 접근성 설정

AutoVoice 플러그인의 접근성 권한을 설정해 보도록 하겠습니다.

기본적으로 시리, 구글 어시스턴트는 지원하지만 국내 삼성에서 개발한 빅스비는 호환되지 않습니다...

안드로이드 유저면 어쩔 수 없이 구글 기능을 사용해야 되는 번거로움이 존재하지만, 음성 기능을 원하는 방행으로 통제하기 위해서는 이것만큼 쉬운 방법도 없습니다.

한번 설정 진행해 보도록 하겠습니다.

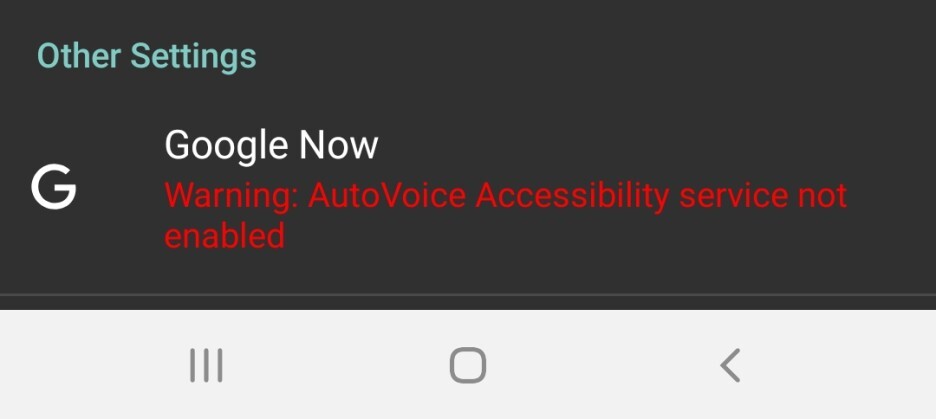

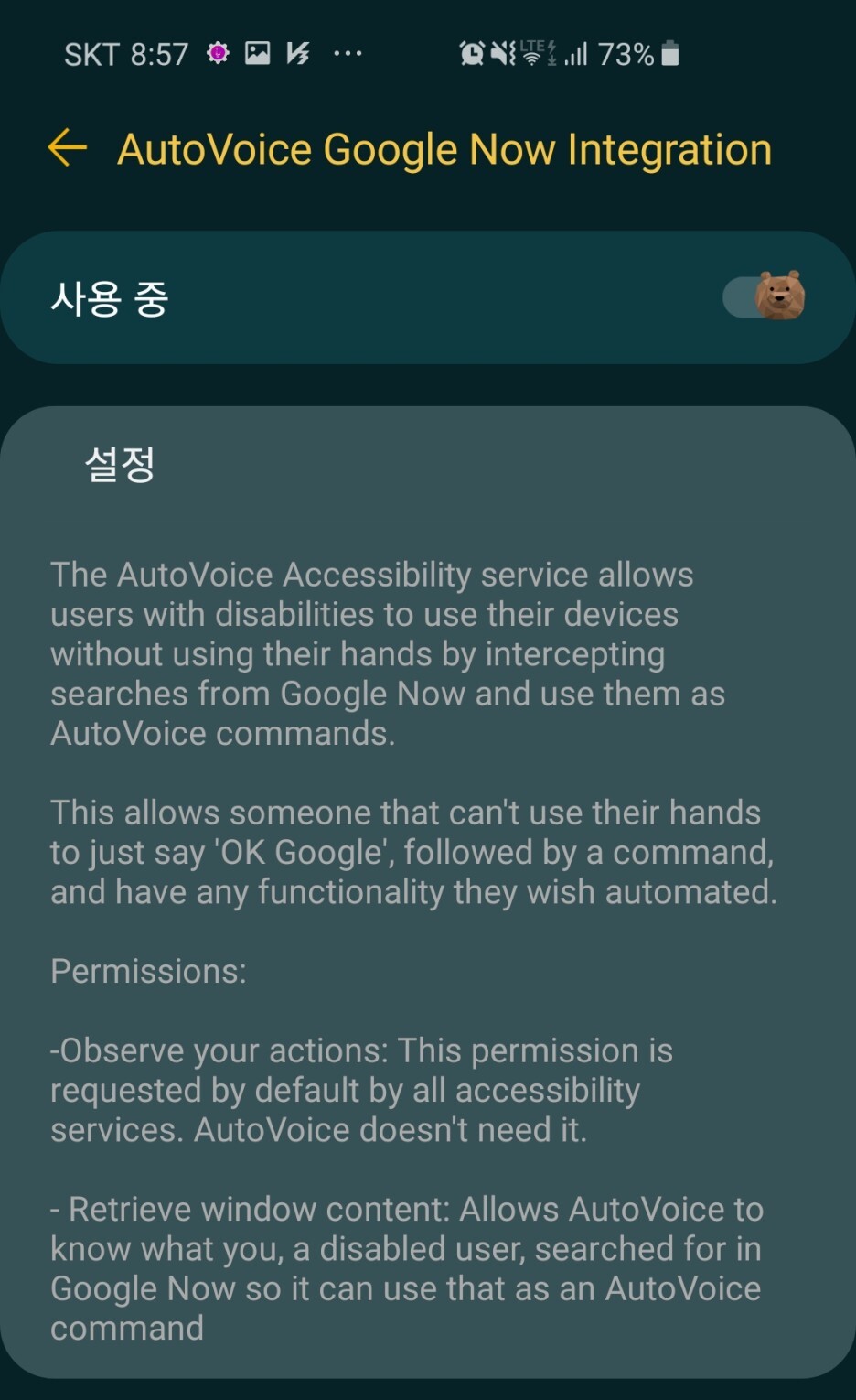

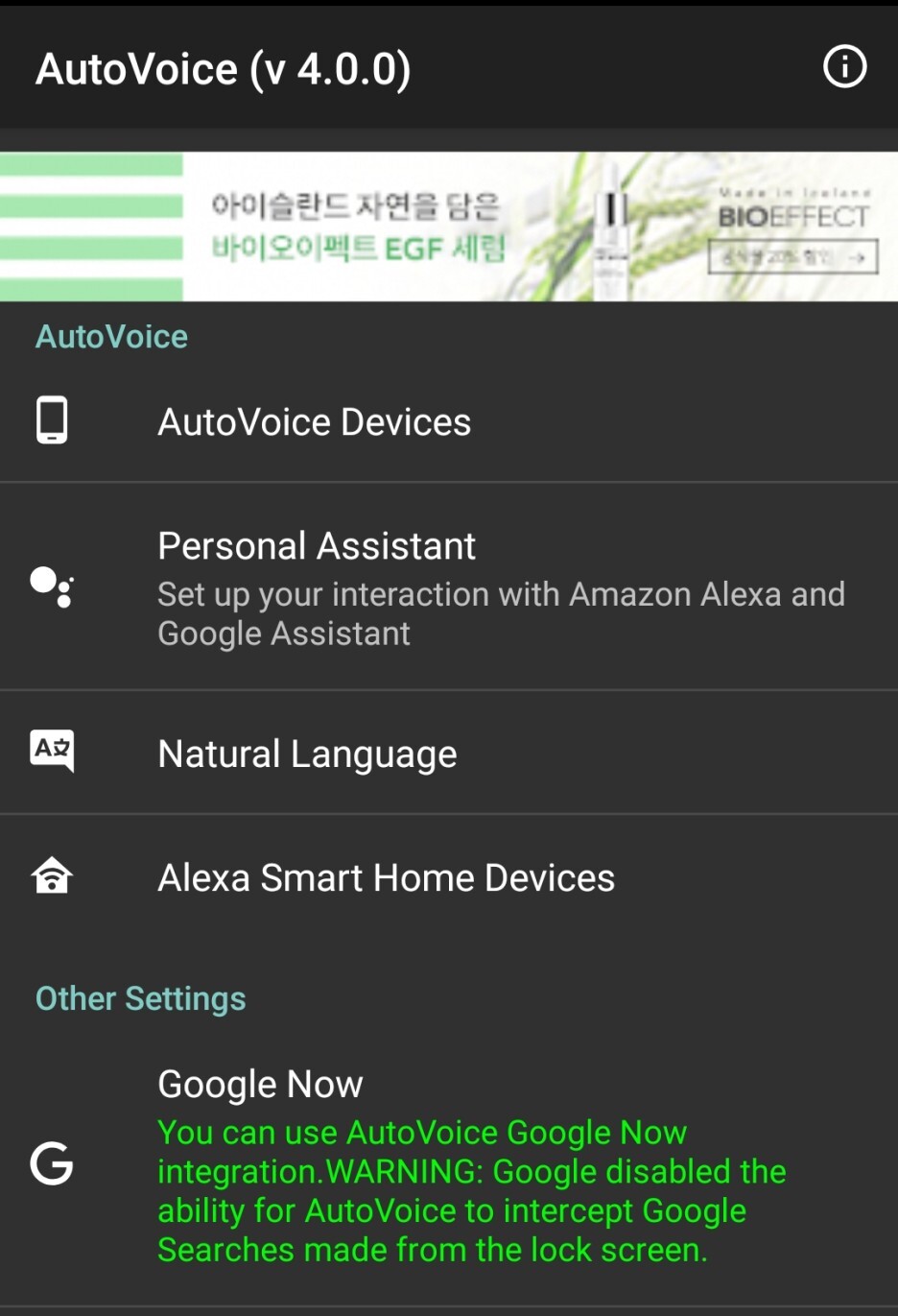

1) AutoVoice 앱을 실행 후 Other setting 탭의 Google Now를 클릭합니다.

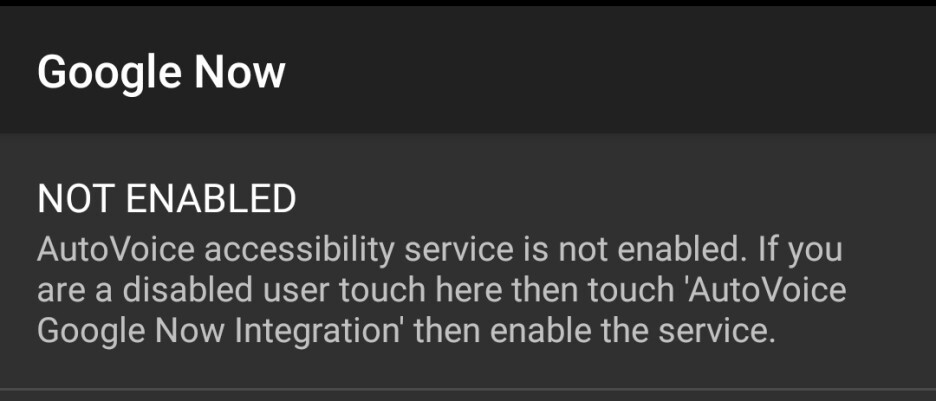

2) NOT ENABLED 탭을 누른 뒤 접근성 화면으로 이동합니다.

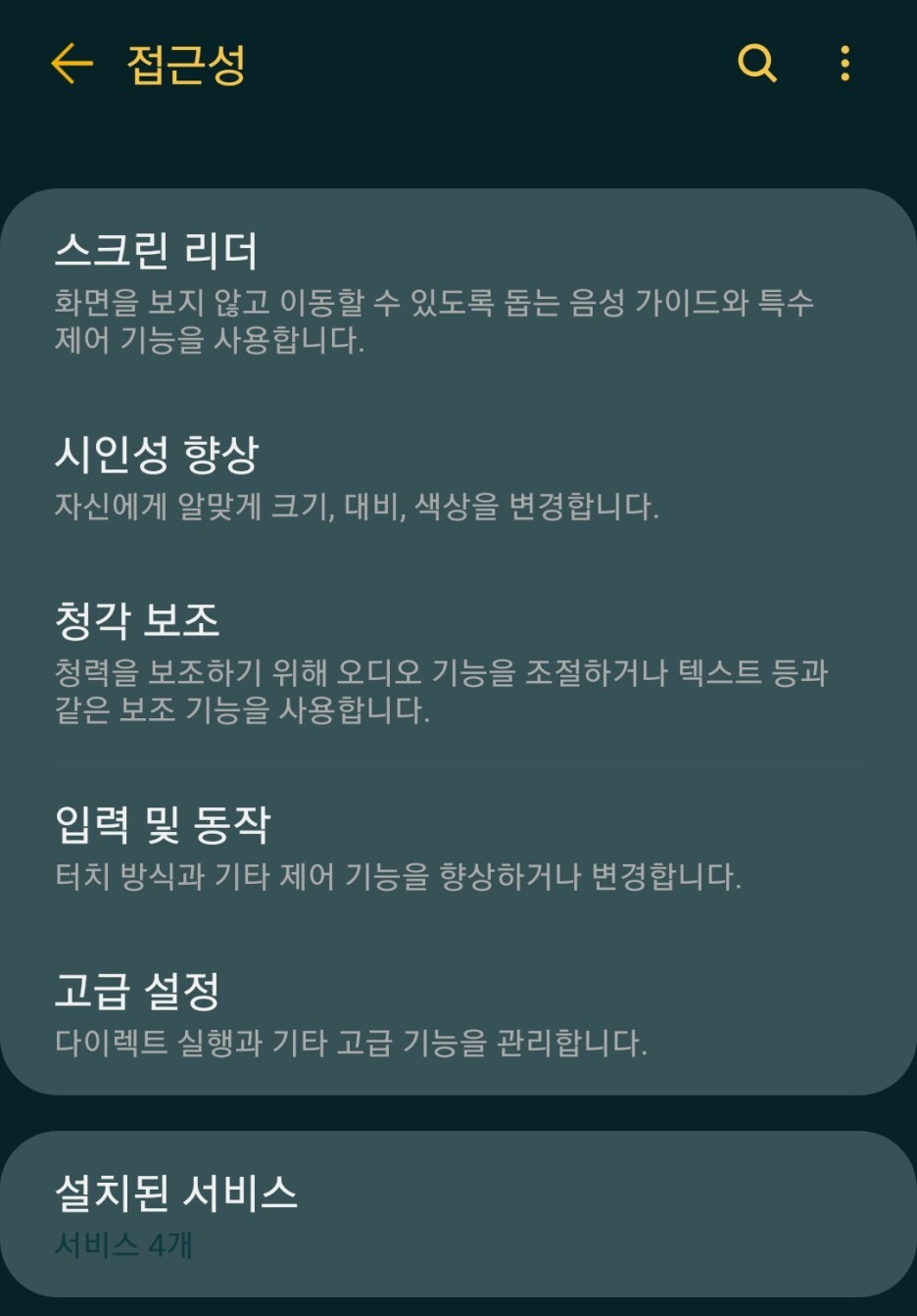

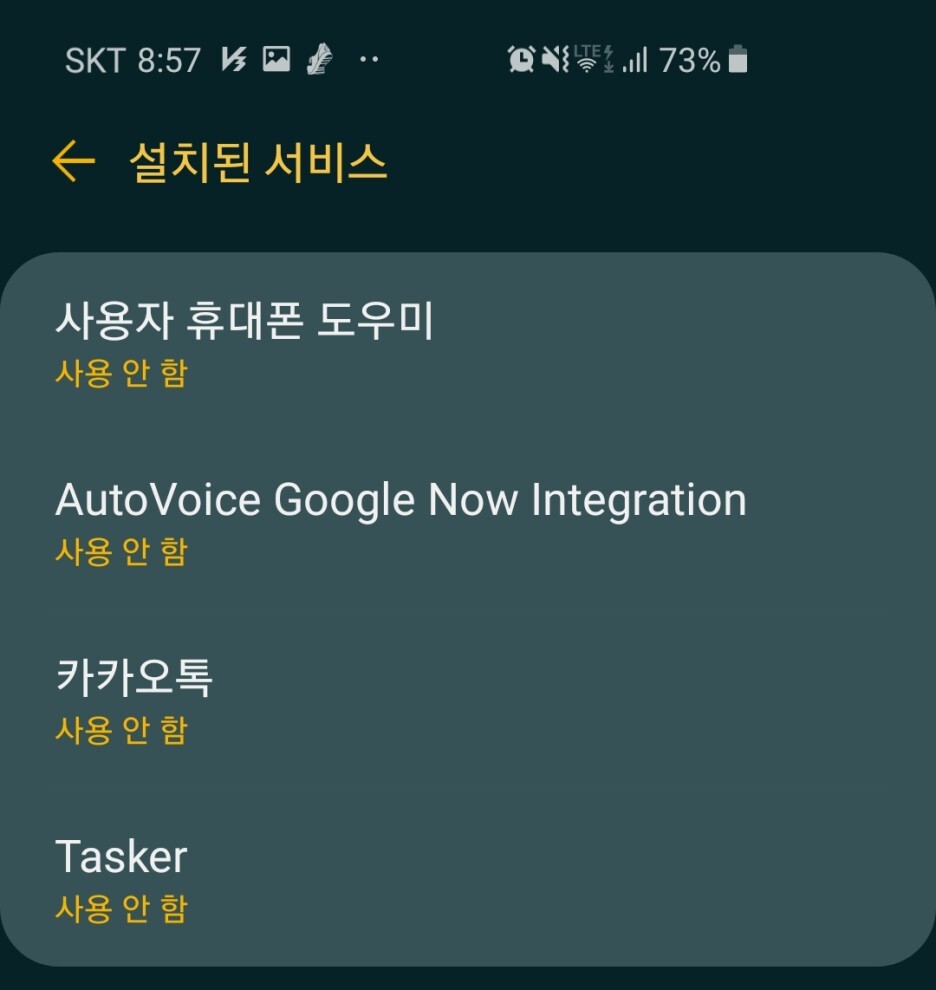

3) 설치된 서비스를 클릭하여 AutoVoice를 클릭하여 접근성 권한을 허용해 줍니다.

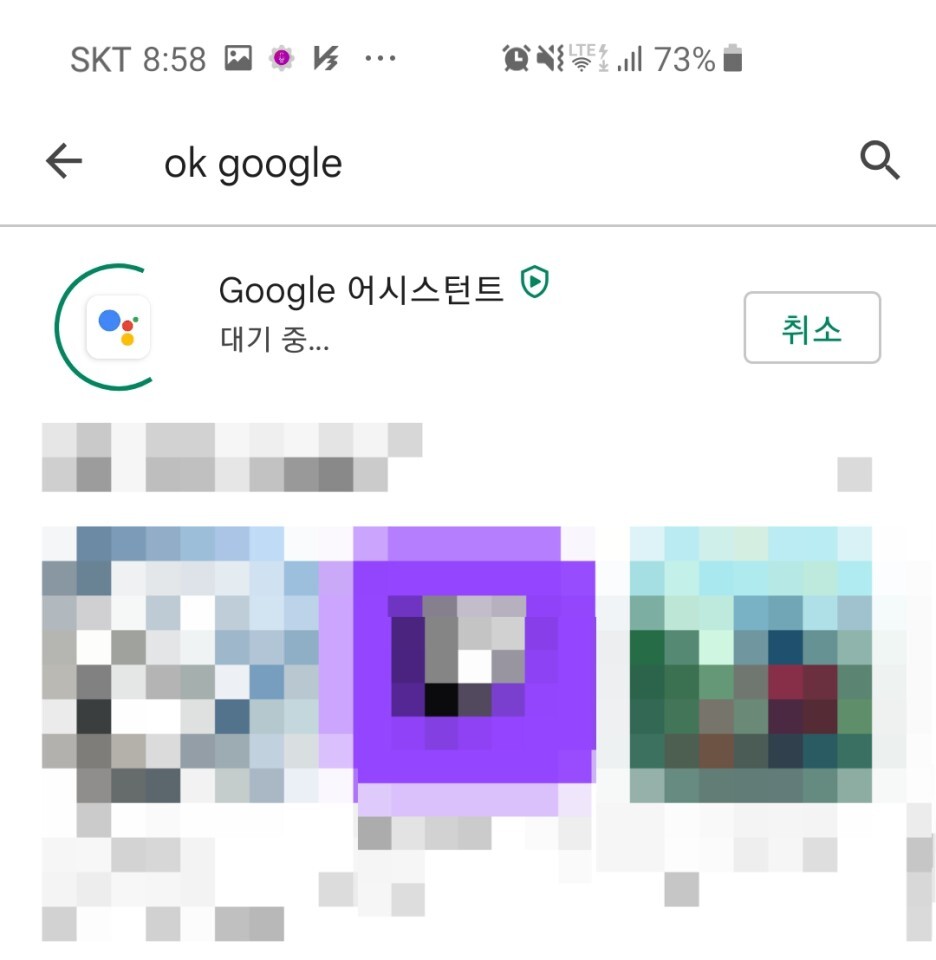

4) 안드로이드 환경에서 연동 가능한 Google 어시스턴트를 설치합니다.

다음으로는 음성인식 명령어를 만들어야 합니다.

엄밀히 말하면 오토 보이스는 구글 어시스턴트의 음성인식 -> 처리결과를 AutoVoice가 중간에 받아와 파싱 한 후 결과 해석 -> 태스커에 전달 순서로 동작하기 때문에 구글 음성인식 엔진을 통해 인식된 음성 데이터의 결과와 매칭이 되도록 설정해 주면 됩니다.

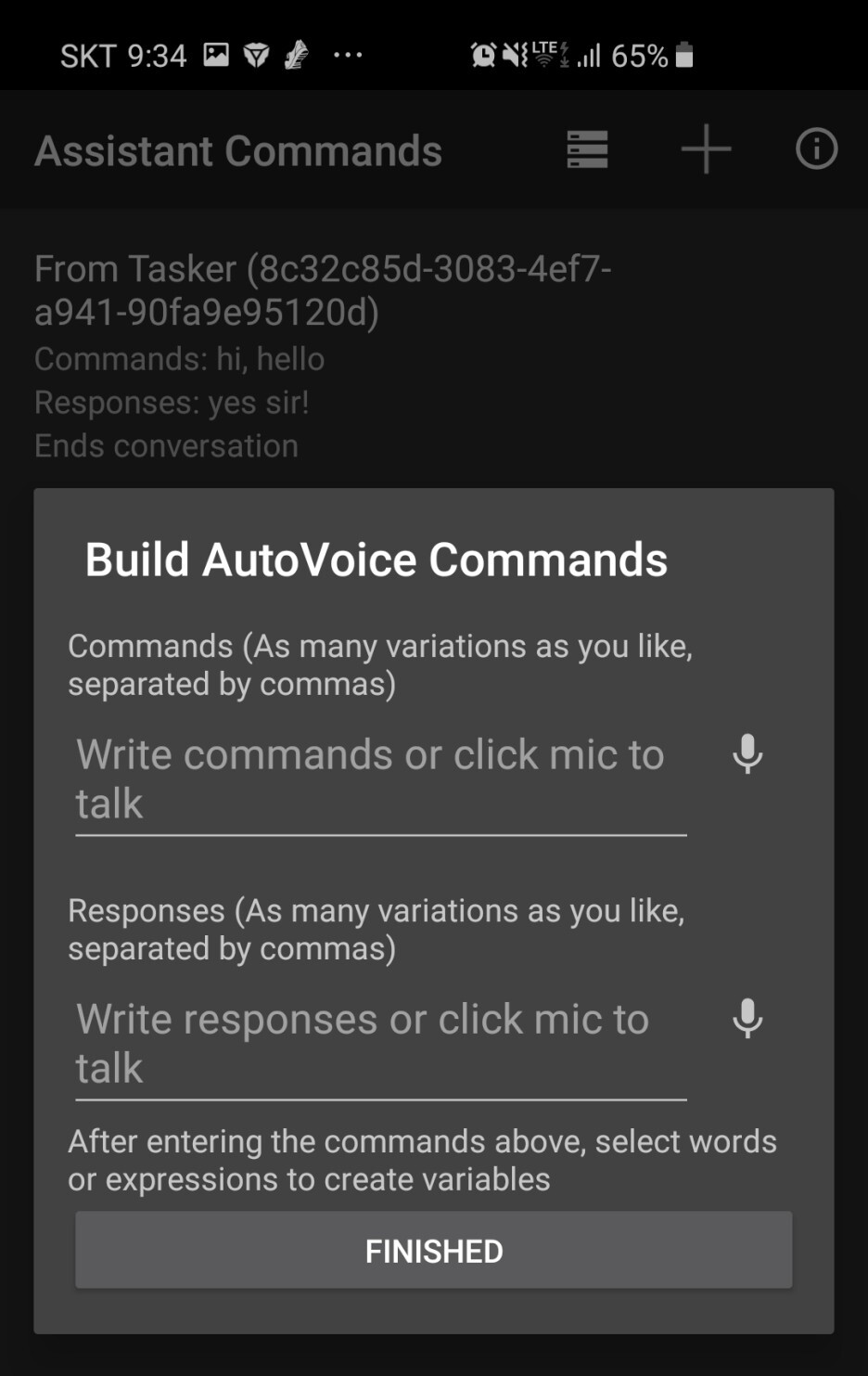

2. Personal Assistant 설정 탭을 클릭합니다.

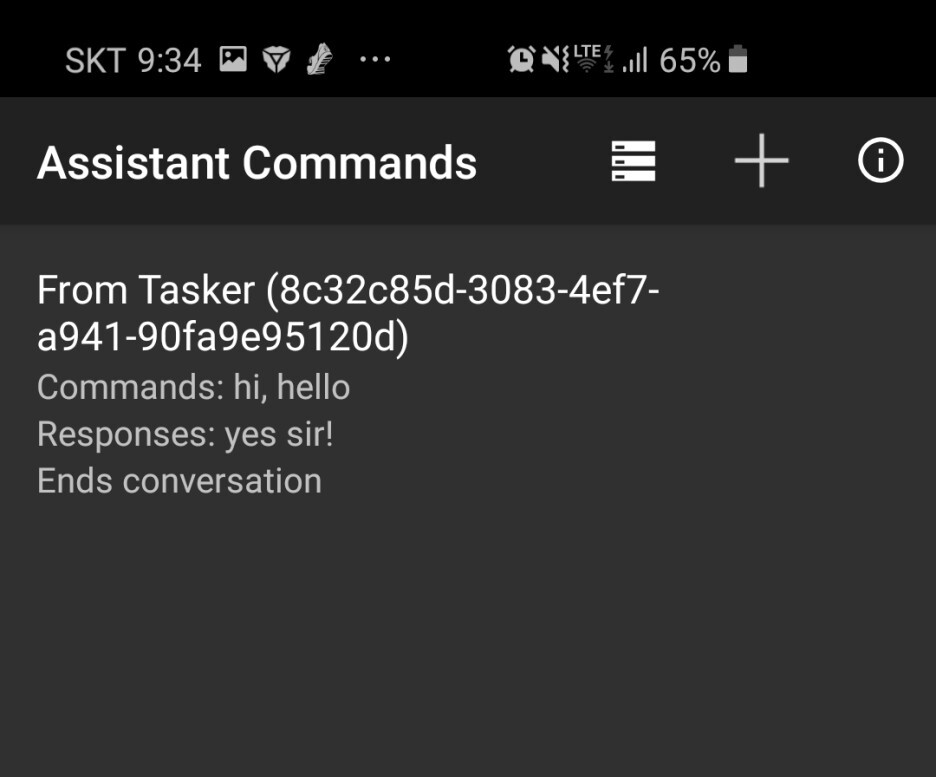

3. 상단 탭의 "+" 버튼을 누른 뒤 추가할 음성 명령어와 대답할 음성 명령어를 작성해 줍니다.

예시)

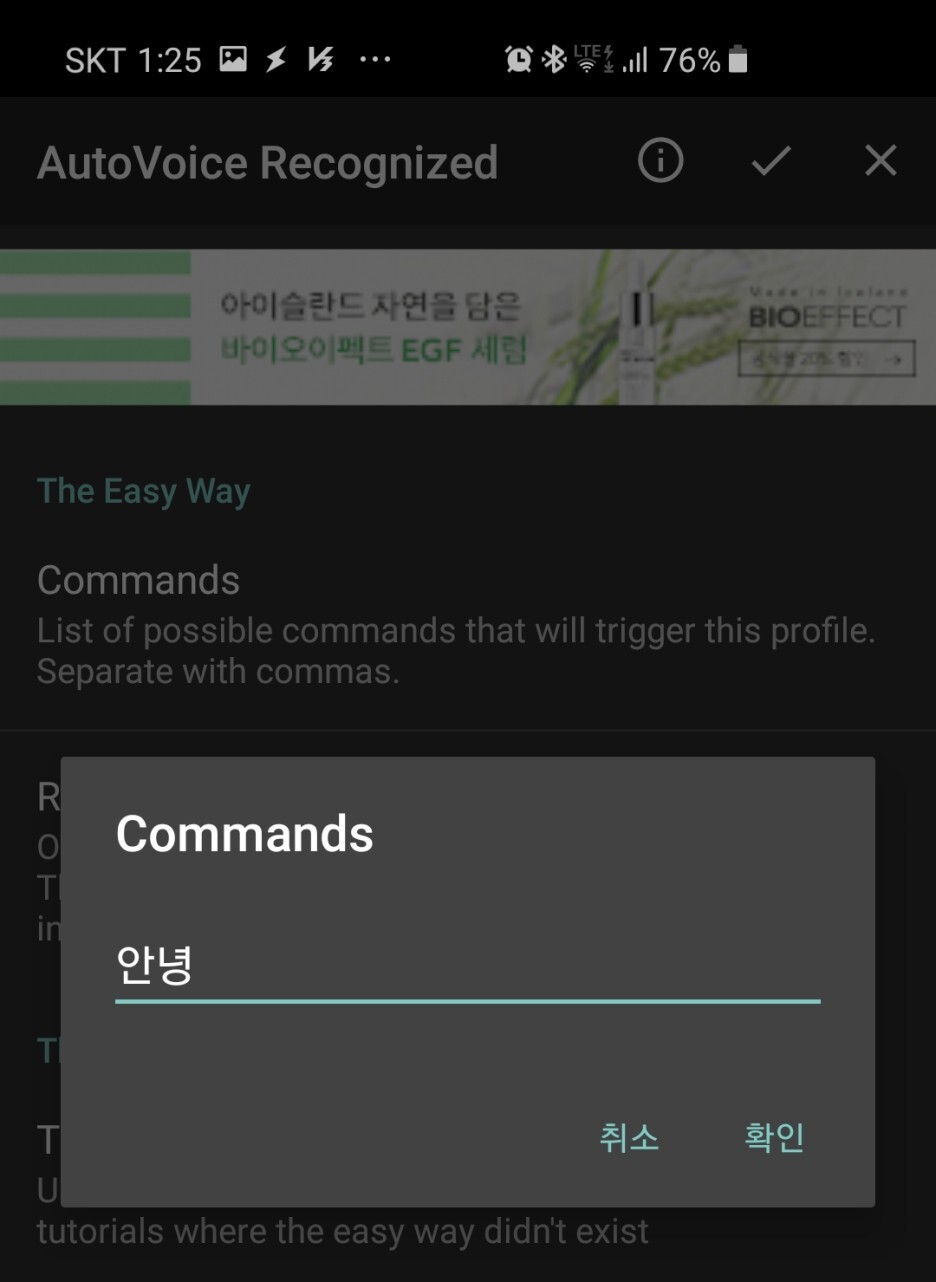

Commands : 안녕, 앙녕, 안령, 앙령

response : 안녕하세요! ICMP 님!

이렇게 설정해 놓으면 "안녕"이라는 음성인식의 오차를 줄이는 것도 가능합니다.

요즘에는 음성 인식 엔진의 인식률이 매우 높아서 위와 같이 설정할 필요가 없는 것 같습니다.

필요에 따라 입맛대로 명령어를 추가해 주시면 될 것 같습니다.

다음으로 태스커에 사용할 명령어를 모두 작성하였으니 이제 태스커와 연동해 보도록 하겠습니다.

우선, 음성인식의 기능을 사용하기 위해서는 다음과 같은 루틴을 거칩니다.

음성인식 엔진을 실행 -> 음성 데이터 해석 결과를 AutoVoice로 전달 -> 결괏값에 따라 태스커의 tasks를 트리거 하여 동작을 실행.

쉽게 말해 우리가 빅스비나 시리를 사용할 때 먼저 "시리야?", "하이 빅스비?"와 같은 명령어로 먼저 음성인식 엔진을 호출한 뒤 구체적인 명령어를 입력하는 것과 같은 맥락이라고 생각하시면 됩니다.

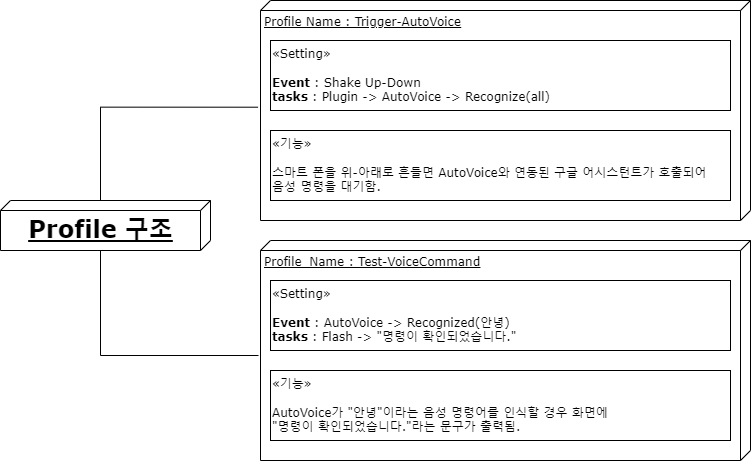

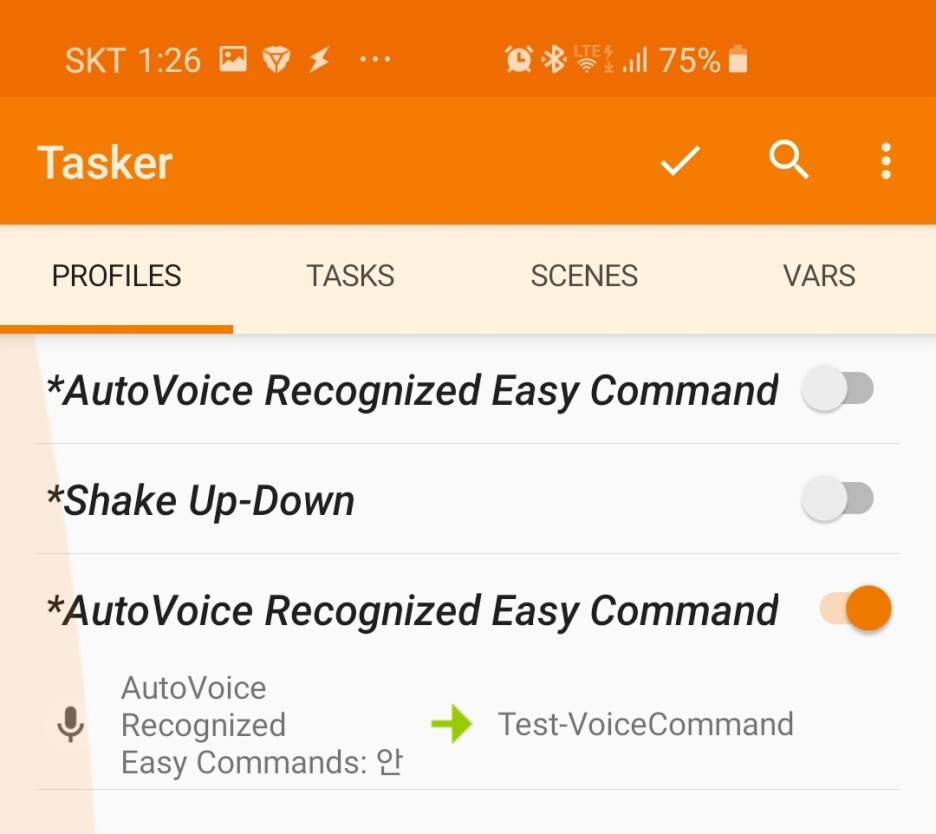

마찬가지로 태스커에 연동하기 위해서는 두 가지 프로파일을 제작해야 하는데 각각의 기능은 다음과 같습니다.

한번 프로파일을 작성해 보도록 하겠습니다.

1. Trigger-AutoVoice

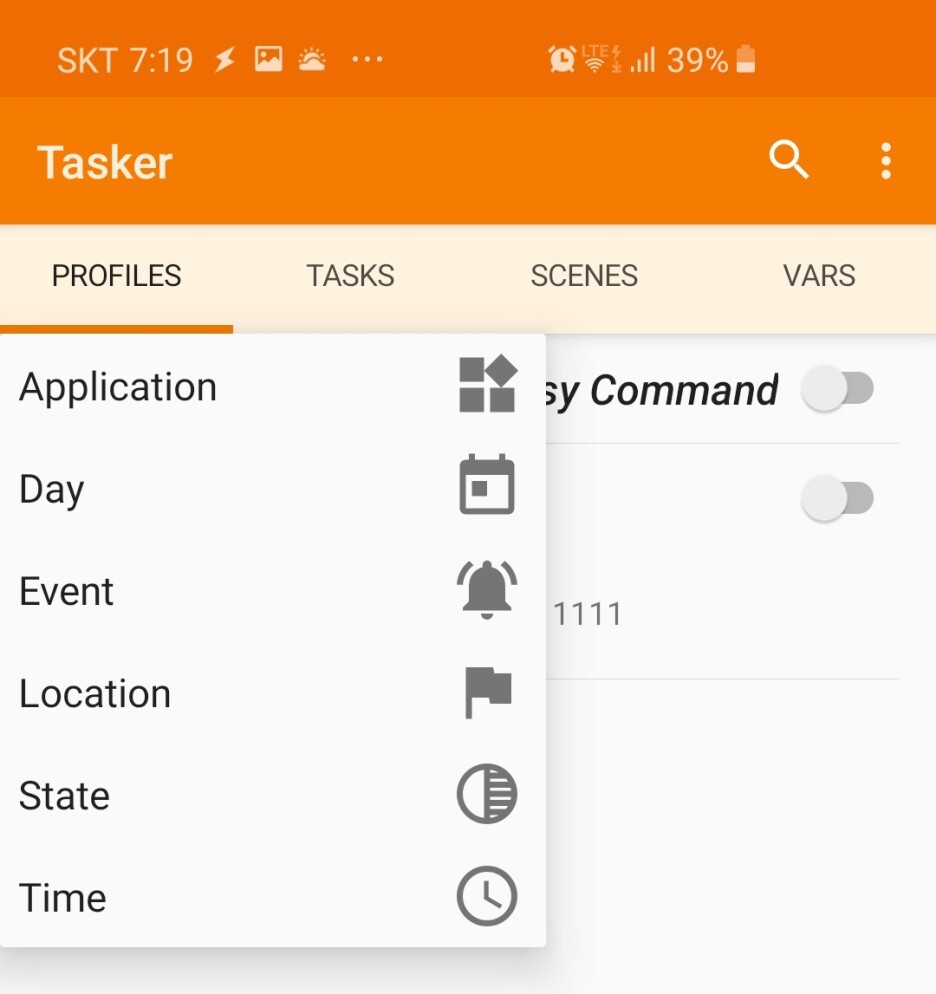

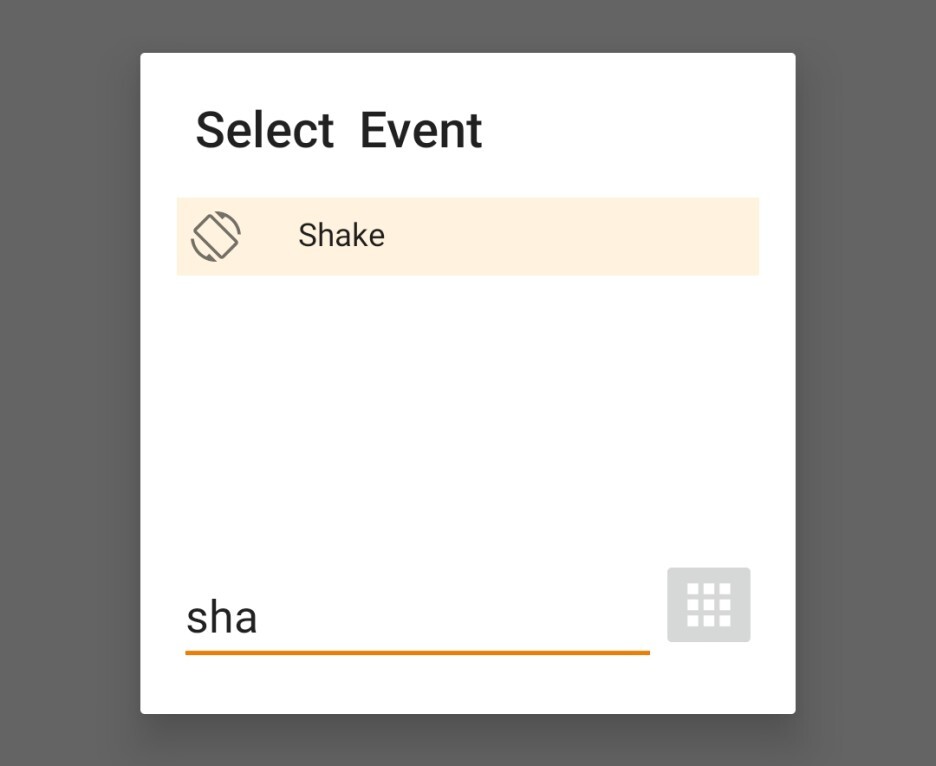

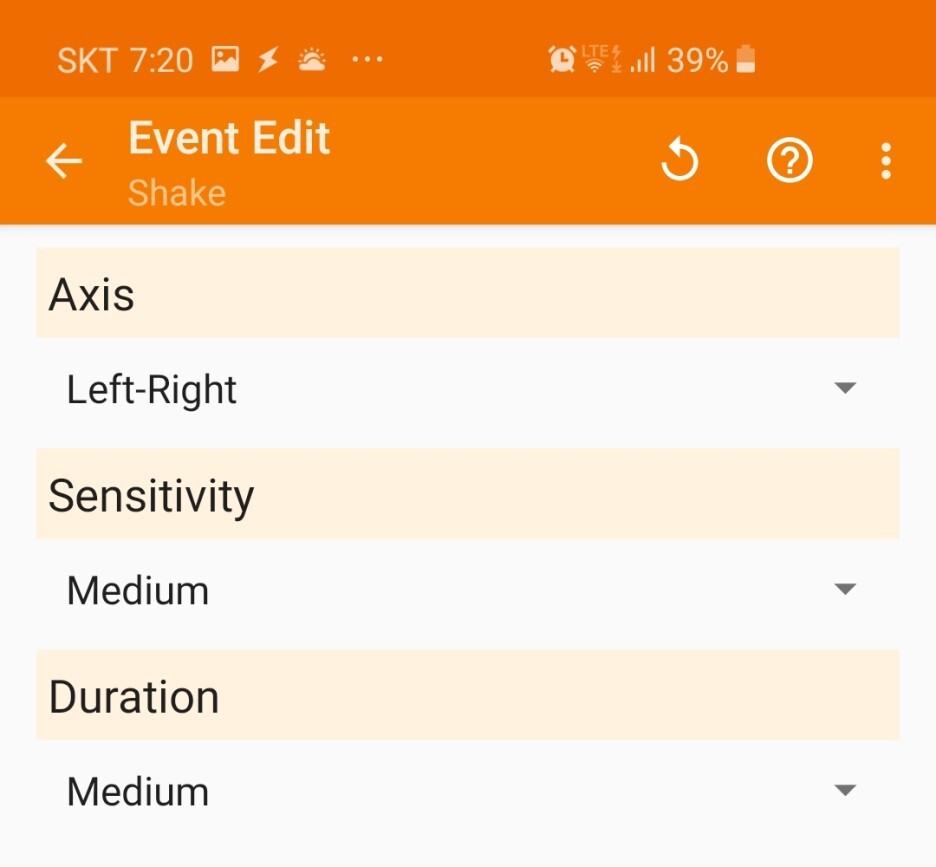

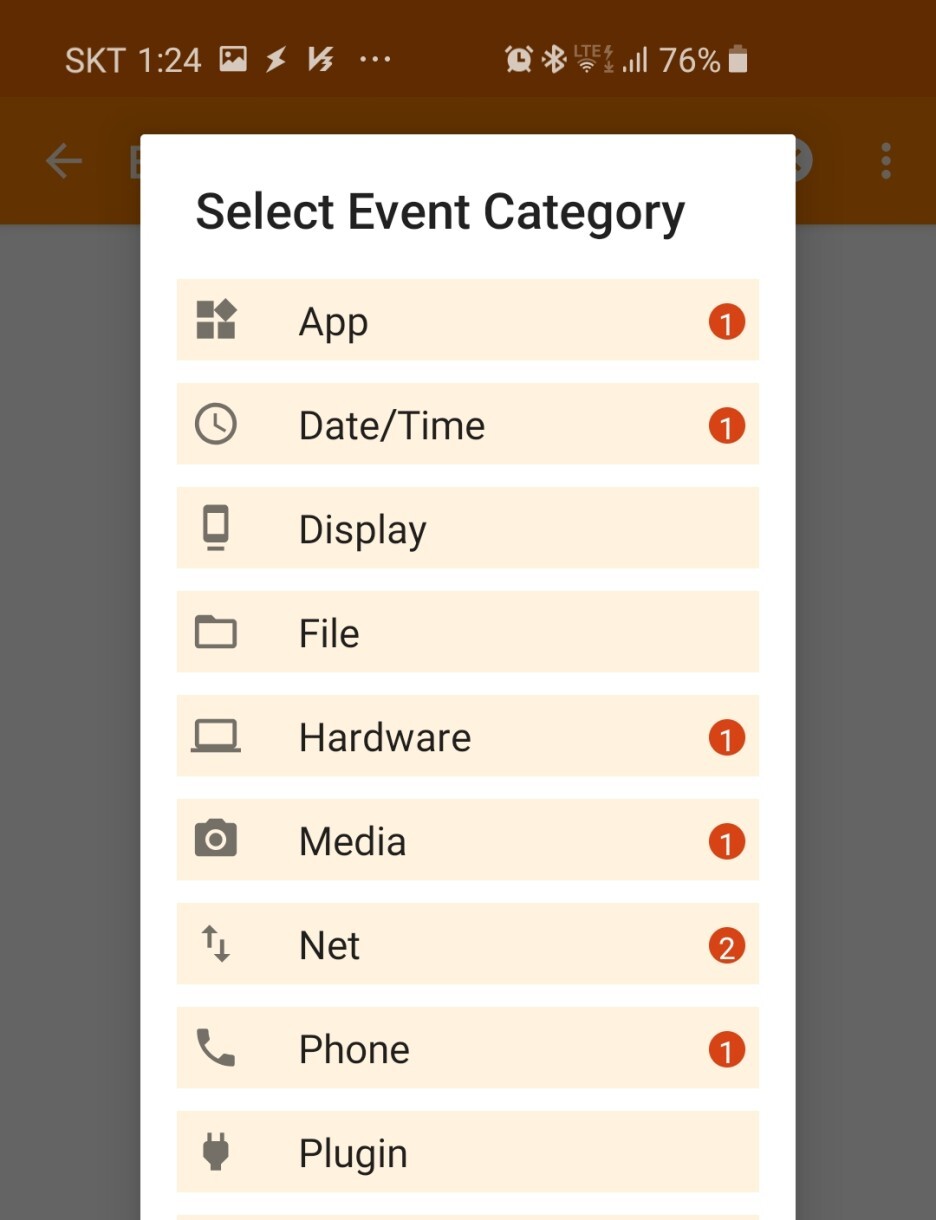

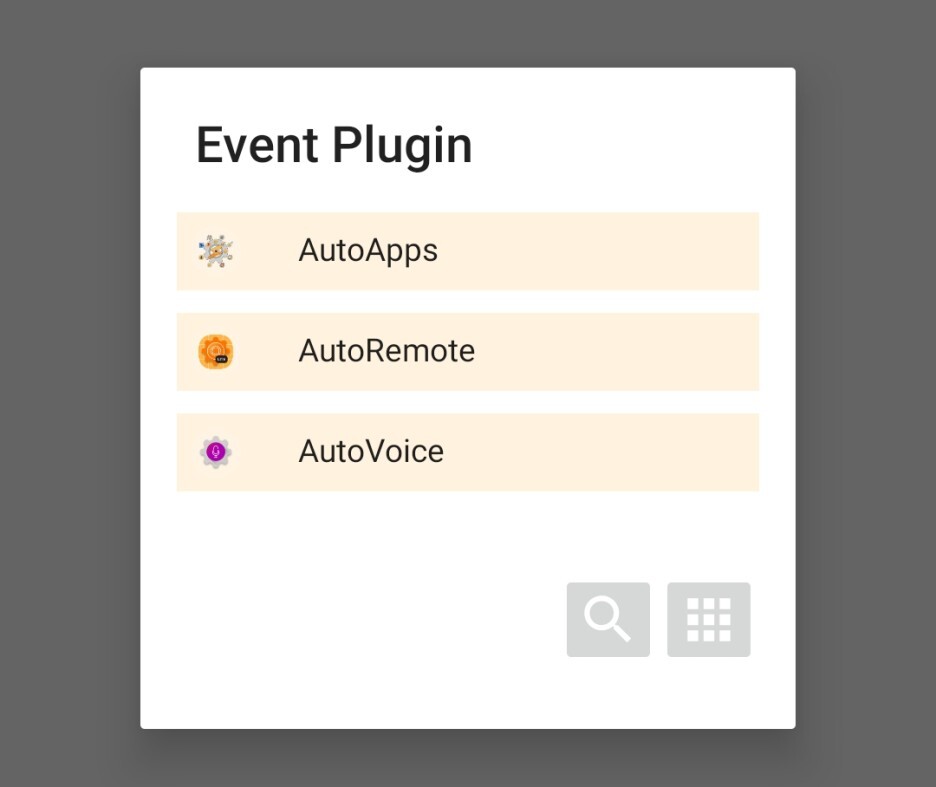

1) Profile create -> Event -> shake(Axis->Up-Down 선택)

- 위와 같이 이벤트를 설정하면, 핸드폰을 위아래로 흔들면 tasks가 트리거 됩니다.

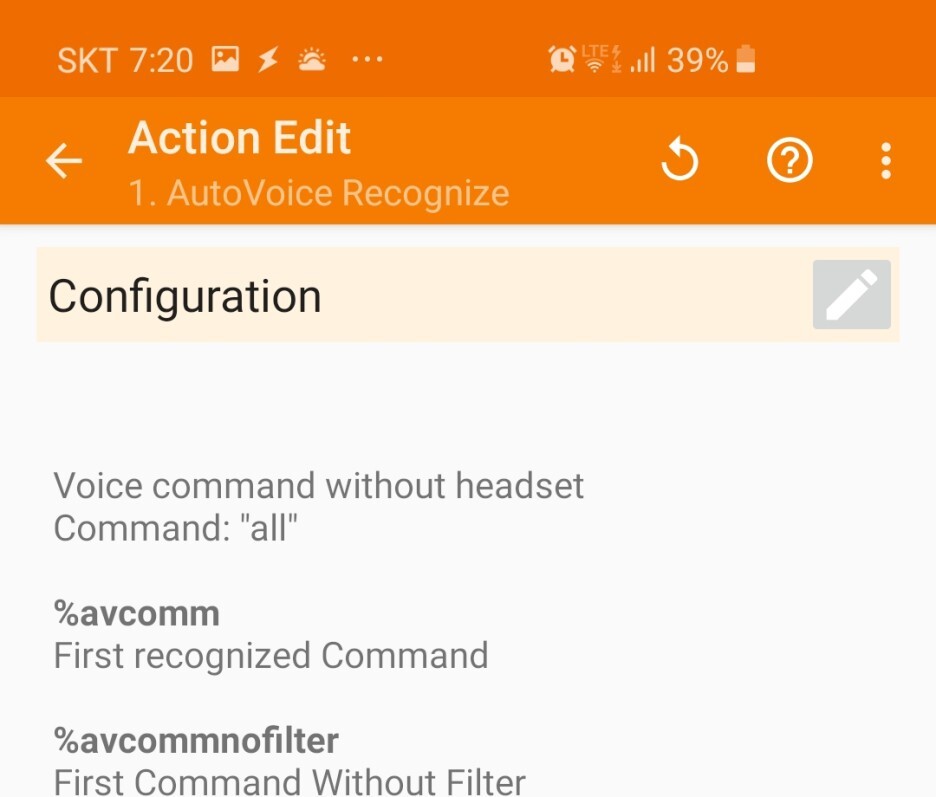

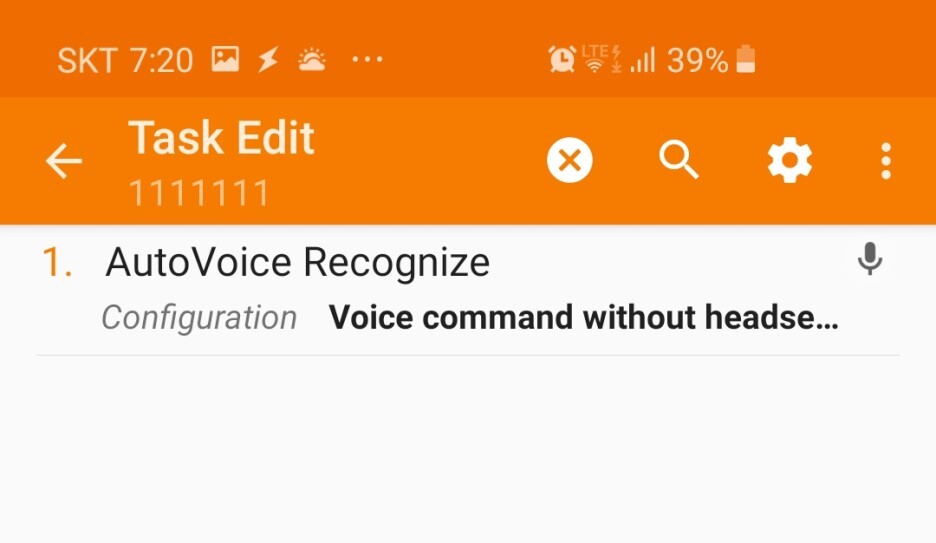

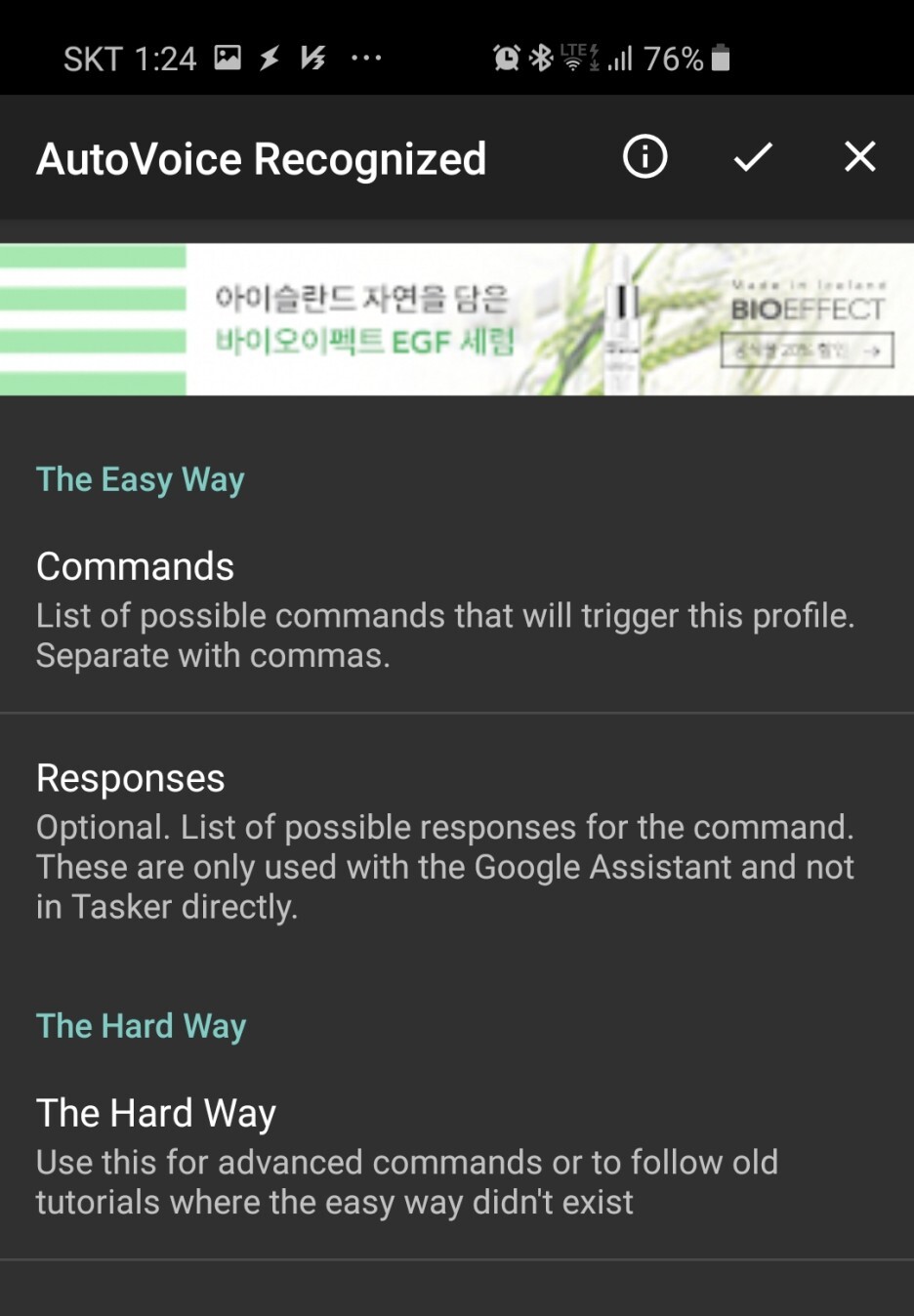

2) tasks 생성 -> plugin(AutoVoice) -> Recognized -> 상단의 연필 모양 아이콘 클릭 후 상단의 체크 버튼 클릭.

- 위 과정을 마무리하면, 조건에 트리거 되면서 구글 음성엔진이 켜지며 명령어 입력 대기 상태로 바뀝니다.

음성 데이터를 입력받기 위한 음성인식 엔진 구동 환경 세팅은 마무리되었습니다.

이제, 입력받은 데이터를 경우에 따라 처리할 수 있도록 세부 동작을 짜보도록 하겠습니다.

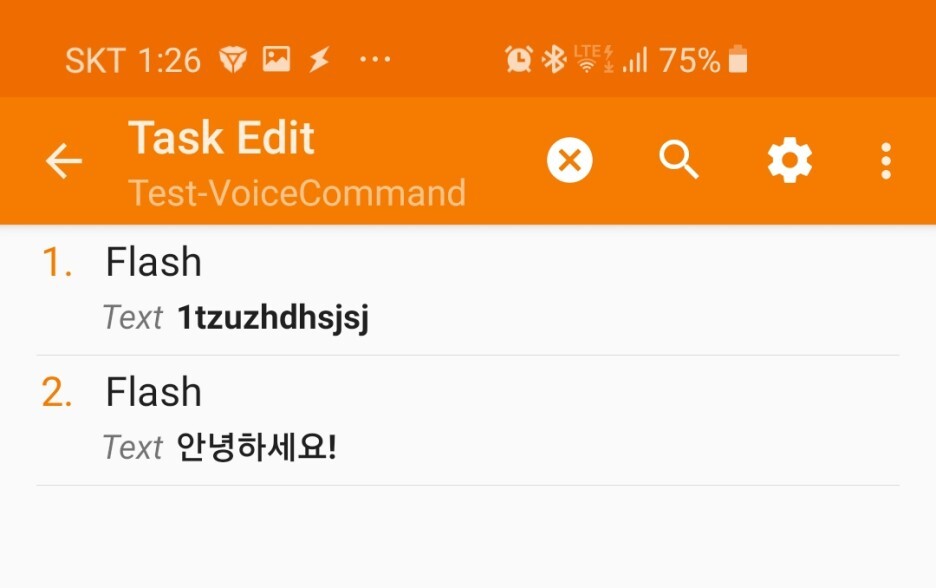

2. Test-VoiceCommand

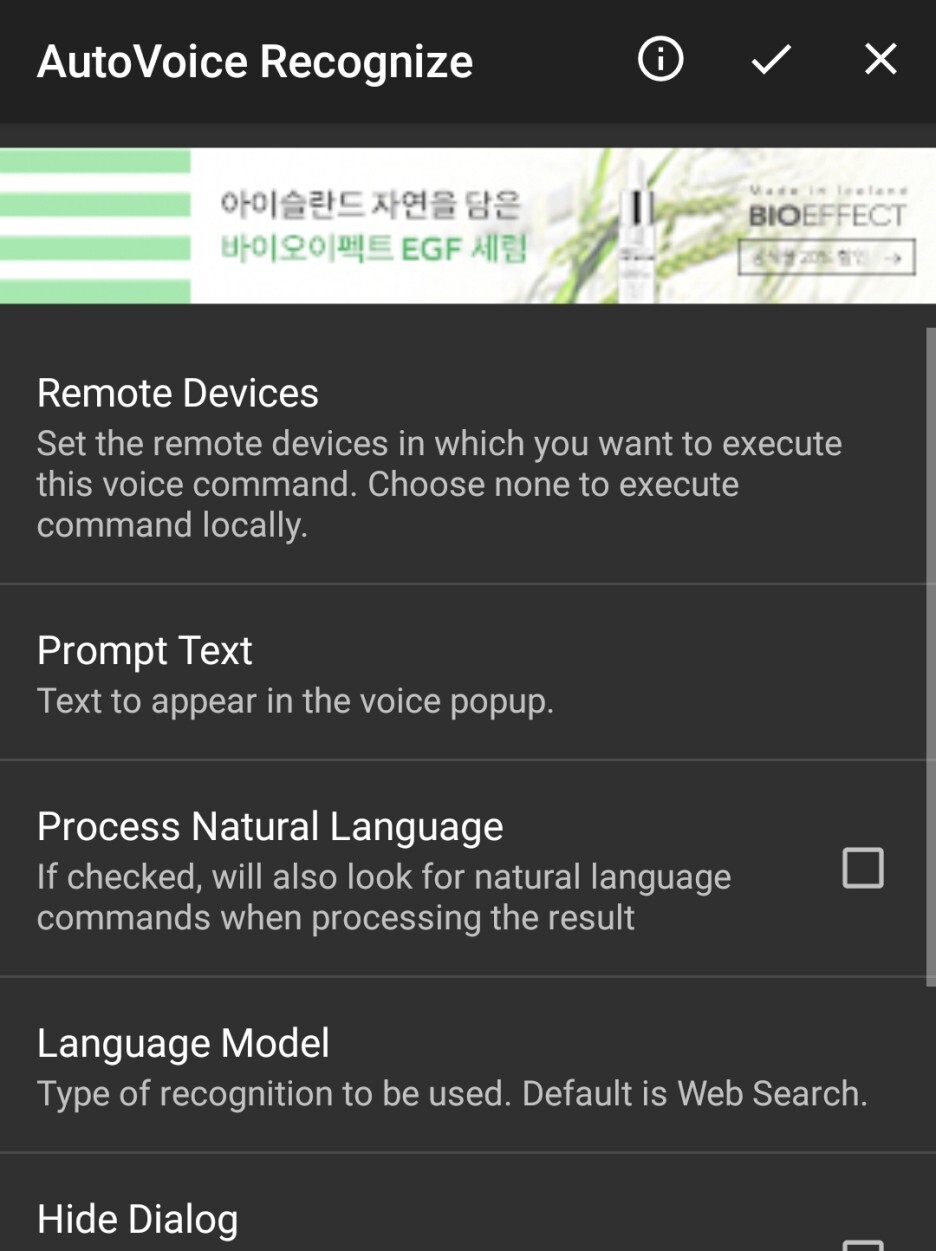

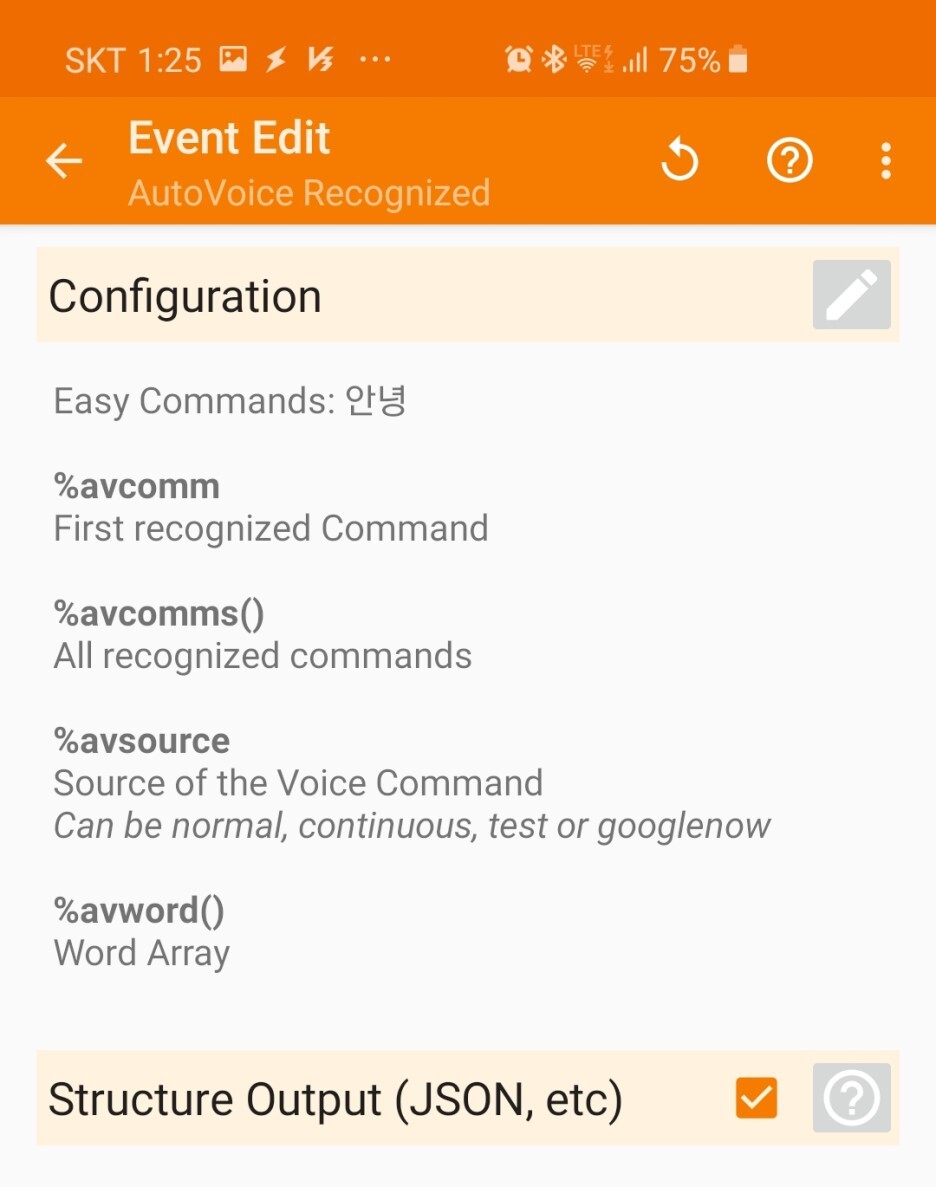

1) Profile create -> Event -> plugin(AutoVoice) -> Recognized -> 상단 연필 모양 아이콘 클릭

-> Commands -> 인식할 음성 명령어 입력 -> 확인 후 상단의 체크 버튼 클릭 후 나오기.

(저는 예제로 "안녕"이라는 음성을 인식하도록 하였습니다.)

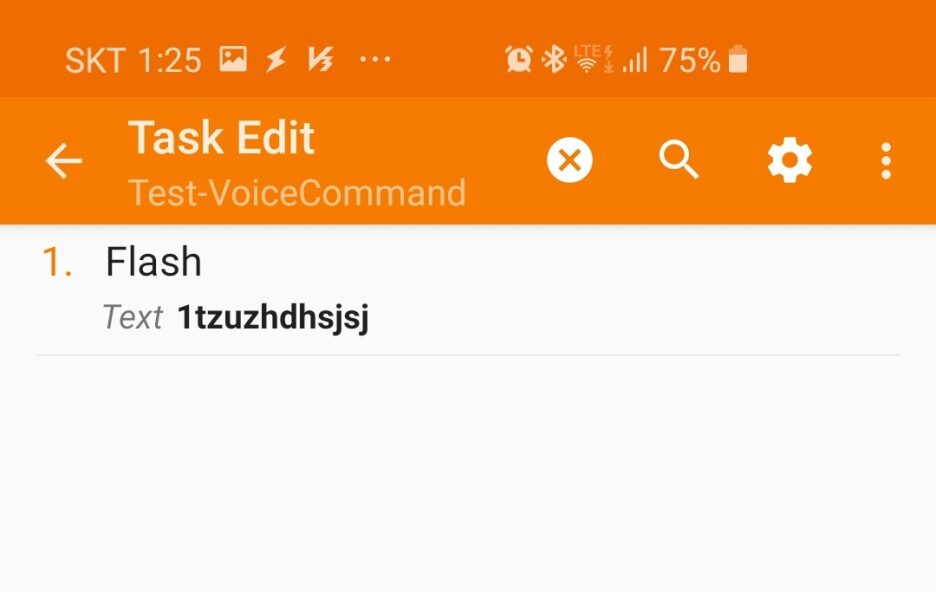

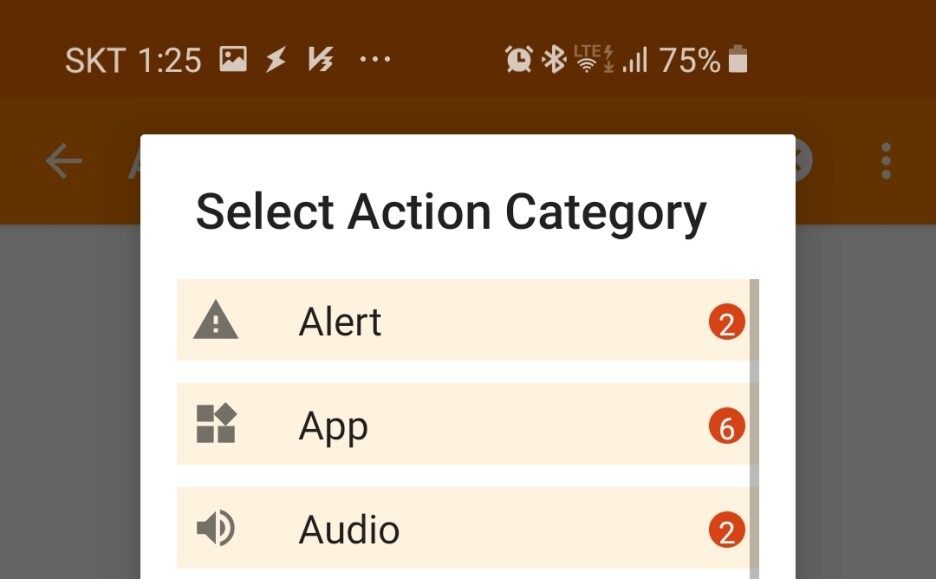

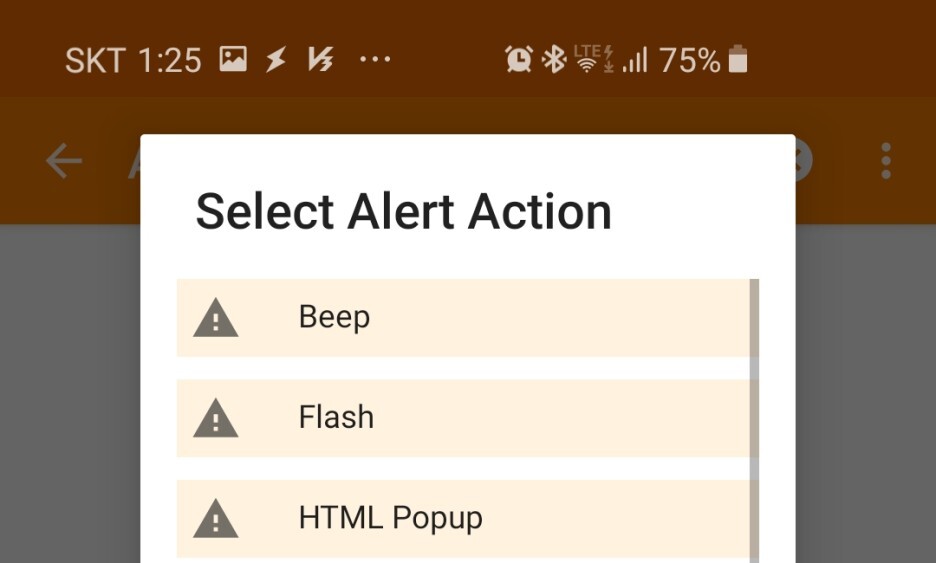

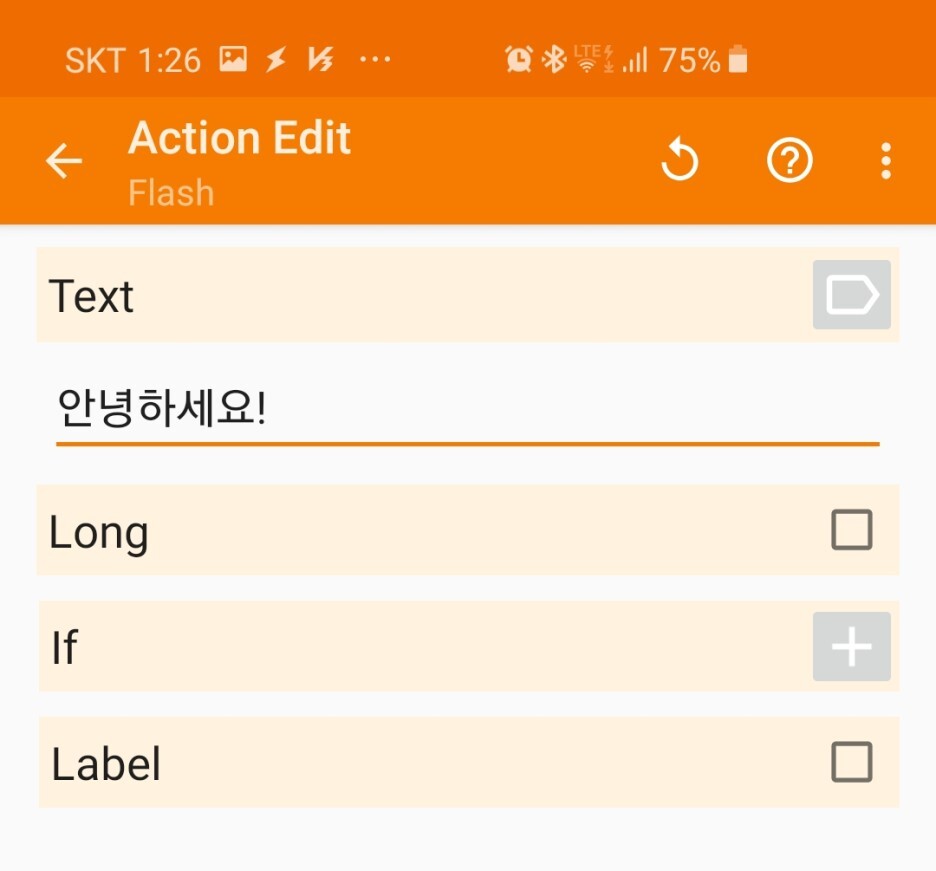

2) tasks -> Alert -> Flash

-> Text -> 출력하고 싶은 문자열을 입력 후 저장.

이제 모두 마무리되었습니다!!!

핸드폰을 위-아래로 흔들고 "안녕"이라고 말하면 화면에 "안녕하세요!"가 출력될 겁니다.

위 예제는 아주 간단한 예제이며, 특정 문장을 말하면 단어를 추출하도록 하여 명령을 실행하도록 할 수 있습니다.

(마치 리눅스 명령어의 옵션 추가 같은 느낌이죠?)

환경적인 제약 때문에 동영상 촬영이 불가능하여 아쉽지만, 제가 만든 프로파일들을 사용할 수 있도록 아래에 업로드해드리도록 하겠습니다.

추가적으로 외국의 한 유저가 아마존 알렉사와 연동하여 기능을 시연하는 영상이 있으니 참고 바랍니다.

(현 버전보다 구 버전이지만, 내부적인 인터페이스는 거의 동일할 겁니다.)

이상! ICMP였습니다.

감사합니다!

'기타 > 태스커(Tasker)' 카테고리의 다른 글

| Tasker plugin - AutoInput (0) | 2022.01.05 |

|---|---|

| 태스커(Tasker) 입문(4) - Action / Alert ( Beep ~ Notify ) (0) | 2019.06.26 |

| 태스커(Tasker) 입문(3) - 조건과 순간 (0) | 2019.06.24 |

| 태스커(Tasker) 입문(2) - 조건과 순간 (0) | 2019.02.03 |

| 태스커(Tasker) 입문(1) - 개발환경 구축과 메인화면 (3) | 2019.01.12 |